Översikt över NVIDIA G-Sync-teknik och ASUS ROG SWIFT PG278Q-skärm. Systemkrav för g-sync hdr Problem med att ansluta till h g sync

Läs också

Vad är vertikal synkronisering i spel? Denna funktion är ansvarig för korrekt visning av spel på vanliga LCD-skärmar med en frekvens på 60 Hz. När den är aktiverad är bildfrekvensen begränsad till 60 Hz och inga avbrott visas på skärmen. Om du inaktiverar det ökar bildfrekvensen, men samtidigt kommer det att finnas en skärmrivningseffekt.

Vad är vertikal synkronisering i spel till för?

V-sync är ett ganska kontroversiellt ämne i spel. Å ena sidan, för en visuellt bekväm spelupplevelse, verkar det vara mycket nödvändigt, förutsatt att du har en vanlig LCD-skärm.

Tack vare det dyker inga fel upp på skärmen under spelet, bilden är stabil och har inga luckor. Nackdelen är att bildfrekvensen är begränsad till 60Hz, så mer krävande spelare kan uppleva ingångsfördröjning, det vill säga en liten fördröjning när de rör sig i spelet med musen (kan likställas med artificiell utjämning av musrörelser).

Att inaktivera vertikal synkronisering har också sina för- och nackdelar. Först och främst tillhandahålls en obegränsad FPS-bildhastighet och tar därmed helt bort den nämnda ingångsfördröjningen. Detta är användbart i spel som Counter-Strike, där reaktion och noggrannhet är viktig. Rörelse och siktning är mycket tydlig, dynamisk, varje rörelse av musen sker med hög precision. I vissa fall kan vi få en högre FPS-hastighet, eftersom V-Sync, beroende på grafikkortet, kan minska hårdvarans prestanda något (skillnaden är cirka 3-5 FPS). Tyvärr är nackdelen att utan vertikal synk får vi en skärmrivningseffekt. När vi vänder eller ändrar rörelse i spelet märker vi att bilden slits i två eller tre horisontella delar.

Aktivera eller inaktivera V-Sync?

Är vertikal synkronisering nödvändig? Allt beror på våra individuella preferenser och vad vi vill få. I multiplayer FPS-spel rekommenderas det att stänga av vertikal synkronisering för att förbättra målnoggrannheten. Skärmrivningseffekten är som regel inte så märkbar, och när vi vänjer oss kommer vi inte ens att märka det.

I sin tur, i sagospel, kan du säkert slå på V-Sync. Här är hög noggrannhet inte så viktigt, första fiolen spelas av miljön, visuell komfort, så du bör satsa på bra kvalitet.

Vertikal synkronisering kan vanligtvis slås på eller av i spelets grafikinställningar. Men om vi inte hittar en sådan funktion där, kan du stänga av den manuellt i grafikkortsinställningarna - både för alla och bara för utvalda applikationer.

Vertikal synk på NVIDIA-grafikkort

På GeForce-grafikkort finns funktionen i Nvidias kontrollpanel. Högerklicka på Windows 10-skrivbordet och välj sedan Nvidia Kontrollpanel.

I sidofältet väljer du fliken Kontroller för 3D-inställningar under 3D-inställningar. De tillgängliga inställningarna kommer att visas till höger.

Inställningarna är uppdelade i två flikar - globalt och program. På den första fliken kan du ställa in alternativ för alla spel och till exempel om du ska aktivera eller inaktivera vertikal synkronisering i varje. På den andra fliken kan du ställa in samma parametrar, men individuellt för varje spel separat.

Välj den globala eller programfliken och leta sedan efter alternativet "Vertikal synkronisering" i listan. Det finns ett rullgardinsfält bredvid - vi väljer att tvinga avstängning eller aktivera vertikal synkronisering.

V-Sync på AMD-grafik

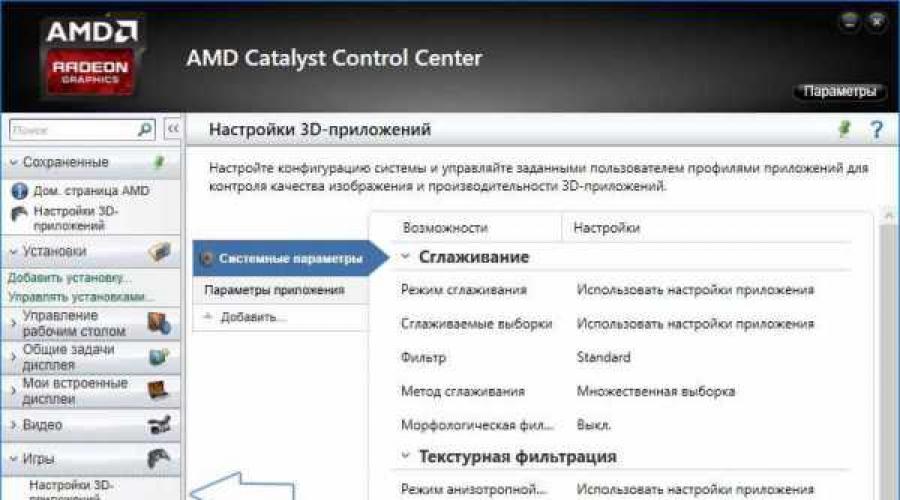

När det gäller AMD-grafikkort ser det exakt likadant ut som i Nvidia. Högerklicka på skrivbordet och gå sedan till Panel Catalyst Control Center.

Öppna sedan fliken "Spel" till vänster och välj "Inställningar för 3D-applikationer". Till höger kommer en lista över tillgängliga alternativ att visas som kan tvingas aktiveras från positionen för AMD Radeons grafikinställningar. När vi är på fliken "Systeminställningar" väljer vi för alla.

Om du behöver ställa in parametrarna individuellt för varje spel separat, bör du klicka på knappen "Lägg till" och ange EXE-filen. Det kommer att läggas till i listan som ett nytt bokmärke, och när du byter till det kan du bara ställa in parametrar för detta spel.

Om du behöver ställa in parametrarna individuellt för varje spel separat, bör du klicka på knappen "Lägg till" och ange EXE-filen. Det kommer att läggas till i listan som ett nytt bokmärke, och när du byter till det kan du bara ställa in parametrar för detta spel.

När du har valt fliken med den tillagda applikationen eller systemparametrarna (allmänt), hittar du alternativet "Vänta på vertikal uppdatering" i listan. En urvalsruta visas där vi kan tvångsaktivera eller inaktivera detta alternativ.

V-Sync på integrerad Intel HD-grafik

Om du använder ett integrerat Intel HD Graphics-chip finns även en kontrollpanel tillgänglig. Den bör vara tillgänglig genom att högerklicka på skrivbordet eller via tangentkombinationen Ctrl+Alt+F12.

På Intel-panelen, gå till fliken Inställningar Läge - Kontrollpanel - 3D-grafik och sedan till användarinställningarna.

Här hittar vi ett fält med vertikal synkronisering Vertical Sync. Du kan aktivera den med tvång genom att ställa in värdet på "Aktiverad" eller ställa in den på "Programinställningar". Tyvärr finns det ingen tvångsinaktiveringsfunktion i Intel HD-kortalternativen - du kan bara aktivera V-Sync. Eftersom det inte är möjligt att inaktivera vertikal synkronisering i grafikkortet kan detta endast göras i själva spelets inställningar.

www.instcomputer.ru

Windows 10 liten FPS och flytande mus :: Counter-Strike: Global Offensive Allmänna diskussioner

Counter-Strike: Global Offensiv > Allmänna diskussioner > ÄmnesinformationWindows 10, liten FPS, flytande mus

God dag alla, jag uppgraderade nyligen mitt system till Win10 (föregående var Win7). Efter uppdateringen stötte jag på flera problem, det första problemet är den relativt låga FPS jämfört med vad det var. Efter att ha installerat Win10 verkar jag ha tappat FPS. Jag förklarar kärnan i problemet, jag har ett genomsnittligt system och på "sjuan" hade jag en bra FPS 200-300. På "tio i topp" stiger inte mitt FPS över 60, varken i menyn eller i själva spelet. Jag letade nästan över hela Internet och hittade ingen lösning på det här problemet. Det andra problemet är en liten mus som flyter, vilket knappt känns, men samtidigt stör det mycket exakt siktning. P.S det här problemet fanns inte innan jag installerade 10. Mitt system: GPU: GeForce GTX 660Ti CPU: ItelCore i3-3220 3.3GHz RAM: 8GB hårddisk (på vilken CS:GO är installerad): 2TB Bildskärm: ASUS VK278 60Hz Mus: Razer DeathAdder 2013 Pad: Razer Goliathus Speed tangentbord: Razer BlackWidow Ultimate 2013

Dela gärna med dig av dina tankar om detta ämne. jag blir väldigt glad)

Obs: Detta ska ENDAST användas för att rapportera spam, reklam och problematiska (trakasserier, slagsmål eller oförskämda) inlägg.

steamcommunity.com

Windows 10-uppdatering låter dig stänga av v-sync och låsa upp max fps

11.05.2016 02:22

Spelprojekt optimerade för Universal Windows Platform (UWP) med DirectX 12-stöd kan köras utan att aktivera alternativet V-Sync. Uppdateringen lägger också till stöd för NVIDIA G-SYNC och AMD FreeSync-teknologier.

Uppdateringen hjälper till att undvika ryckningar och förseningar på skärmen, samt förbättra bildens visuella kvalitet.

Microsoft har uppgett att Gears of War: Ultimate Edition och Forza Motorsport 6: Apex kommer att få patchar med detta alternativ inom en mycket nära framtid.

Automatisk uppdatering kommer gradvis till alla datorer med den "tionde" versionen av Windows.

G-Sync teknik översikt | En kort historik över fasta uppdateringsfrekvenser

En gång i tiden var monitorer skrymmande och innehöll katodstrålerör och elektronkanoner. Elektronpistoler bombarderar skärmen med fotoner för att lysa upp färgade fosforprickar, som vi kallar pixlar. De ritar från vänster till höger varje "scan" linje uppifrån och ned. Att justera hastigheten på elektronkanonen från en full uppgradering till nästa var inte särskilt övat innan, och det fanns inget särskilt behov av detta innan tredimensionella spel kom. Därför designades CRT och relaterade analoga videostandarder med en fast uppdateringsfrekvens.

LCD-skärmar ersatte gradvis CRT:er och digitala kontakter (DVI, HDMI och DisplayPort) ersatte de analoga (VGA). Men de föreningar som ansvarar för standardisering av videosignaler (ledda av VESA) har inte gått från en fast uppdateringsfrekvens. Filmer och tv är fortfarande beroende av konstant bildhastighet. Återigen verkar det inte nödvändigt att byta till en variabel uppdateringsfrekvens.

Justerbara bildfrekvenser och fasta uppdateringsfrekvenser matchar inte

Före tillkomsten av modern 3D-grafik var fasta uppdateringsfrekvenser inte ett problem för skärmar. Men det uppstod när vi först stötte på kraftfulla GPU:er: hastigheten med vilken GPU:n renderade individuella bildrutor (det vi kallar bildhastighet, vanligtvis uttryckt i FPS eller bildrutor per sekund) är inkonsekvent. Det förändras med tiden. I tunga grafikscener kan kortet ge 30 FPS, och om man tittar på den tomma himlen - 60 FPS.

Inaktivering av synkronisering orsakar rivning

Det visar sig att den variabla bildfrekvensen för GPU:n och den fasta uppdateringsfrekvensen för LCD-panelen inte fungerar särskilt bra tillsammans. I den här konfigurationen står vi inför en grafisk artefakt som kallas "gap". Det inträffar när två eller flera ofullständiga bildrutor renderas tillsammans under en bildskärmsuppdateringscykel. Vanligtvis är de förskjutna, vilket ger en mycket obehaglig effekt under rörelse.

Bilden ovan visar två välkända artefakter som ofta hittas men svåra att fånga. Eftersom dessa är visningsartefakter kommer du inte att se dem i vanliga spelskärmdumpar, men våra skärmdumpar visar vad du faktiskt ser under spelet. För att fotografera dem behöver du en kamera med ett höghastighetsfotograferingsläge. Eller om du har ett videoinspelningskort kan du spela in en okomprimerad videoström från DVI-porten och tydligt se övergången från en bildruta till nästa; det är så vi använder för FCAT-tester. Det är dock bäst att observera den beskrivna effekten med dina egna ögon.

Rivningseffekten är synlig på båda bilderna. Den översta görs med kameran, den nedersta är genom videoinspelningsfunktionen. Den nedre bilden är "skivad" horisontellt och ser feljusterad ut. I de två översta bilderna togs den vänstra bilden på en Sharp-skärm vid 60Hz, den högra bilden på en Asus-skärm vid 120Hz. Rivningen på 120Hz-skärmen är inte lika uttalad eftersom uppdateringsfrekvensen är dubbelt så hög. Effekten är dock synlig och visas på samma sätt som i den vänstra bilden. Denna typ av artefakt är en tydlig indikation på att bilderna togs med vertikal synk (V-sync) inaktiverad.

Battlefield 4 på GeForce GTX 770 med V-sync inaktiverad

Den andra effekten som ses i BioShock: Infinite footage kallas spökbilder. Det är särskilt synligt längst ner i den vänstra bilden och är relaterat till fördröjningen av skärmens uppdatering. Kort sagt, enskilda pixlar ändrar inte färg tillräckligt snabbt, vilket resulterar i denna typ av glöd. En enda bildruta kan inte förmedla effekten av spökbilder på själva spelet. En panel med 8 ms grå-till-grå svarstid, som Sharp, kommer att resultera i en suddig bild med alla rörelser på skärmen. Det är därför dessa skärmar i allmänhet inte rekommenderas för FPS-spel.

V-sync: "en sy på tvålen"

Vertikal synk, eller V-synk, är en mycket gammal lösning för att riva. När den här funktionen är aktiverad försöker grafikkortet matcha skärmens uppdateringsfrekvens genom att helt ta bort rivning. Problemet är att om ditt grafikkort inte kan hålla bildfrekvensen över 60 FPS (på en 60Hz-skärm), kommer den effektiva bildfrekvensen att hoppa mellan multiplar av skärmens uppdateringsfrekvens (60, 30, 20, 15 FPS, etc. ). etc.), vilket i sin tur kommer att leda till märkbar inbromsning.

När bildfrekvensen sjunker under uppdateringsfrekvensen med V-sync aktiv kommer du att uppleva stamning

Dessutom, eftersom vsync får grafikkortet att vänta och ibland förlitar sig på den osynliga ytbufferten, kan V-sync lägga till ytterligare ingångslatens till renderingskedjan. Således kan V-sync vara både en räddning och en förbannelse, lösa vissa problem samtidigt som det orsakar andra nackdelar. En informell undersökning av vår personal visade att spelare tenderar att stänga av v-sync och bara slå på den när det blir outhärdligt att riva.

Bli kreativ: Nvidia introducerar G-Sync

När du startar ett nytt grafikkort GeForce GTX 680 Nvidia har inkluderat ett drivrutinsläge som heter Adaptive V-sync, som försöker mildra problemen med att aktivera V-sync när bildfrekvensen är över bildskärmens uppdateringsfrekvens, och snabbt stänga av den när prestandan faller kraftigt under uppdateringsfrekvensen. Även om tekniken troget utförde sin funktion, var det bara en lösning som inte eliminerade rivning om bildfrekvensen var lägre än bildskärmens uppdateringsfrekvens.

Genomförande G-synk mycket mer intressant. Generellt sett visar Nvidia att istället för att tvinga grafikkort att köra med en fast visningsfrekvens, kan vi tvinga nya bildskärmar att köra med en variabel frekvens.

GPU-bildhastigheten bestämmer bildskärmens uppdateringsfrekvens och tar bort artefakter som är associerade med att aktivera och inaktivera V-sync

Paketdataöverföringsmekanismen i DisplayPort-kontakten har öppnat nya möjligheter. Genom att använda variabla släckningsintervall i DisplayPort-videosignalen och ersätta bildskärmsskalaren med en variabel släckningsmodul, kan LCD-panelen arbeta med en variabel uppdateringsfrekvens relaterad till bildfrekvensen som matas ut av grafikkortet (inom bildskärmens uppdateringsfrekvens). I praktiken har Nvidia varit kreativa med att använda specialfunktionerna i DisplayPort-gränssnittet och försökt fånga två flugor i en smäll.

Redan innan testerna börjar vill jag ge äran för det kreativa sättet att lösa ett verkligt problem som påverkar PC-spel. Detta är innovation när den är som bäst. Men vad blir resultatet G-synk på praktik? Låt oss ta reda på.

Nvidia skickade oss ett tekniskt prov av monitorn Asus VG248QE, där skalaren ersätts av en modul G-synk. Vi är redan bekanta med denna display. Artikeln är tillägnad honom "Asus VG248QE recension: 400 $ 24" 144Hz spelskärm", som bildskärmen fick utmärkelsen Tom's Hardware Smart Buy i. Nu är det dags att ta reda på hur Nvidias nya teknik kommer att påverka de mest populära spelen.

G-Sync teknik översikt | 3D LightBoost, inbyggt minne, standarder och 4K

När vi bläddrade i Nvidias pressmeddelanden ställde vi oss en hel del frågor, både om teknikens plats i nuet och dess roll i framtiden. Under en resa nyligen till företagets huvudkontor i Santa Clara fick våra amerikanska kollegor några svar.

G-Sync och 3D LightBoost

Det första vi märkte är att Nvidia skickade bildskärmen Asus VG248QE, modifierad för att stödja G-synk. Denna bildskärm stöder även Nvidias 3D LightBoost-teknik, som ursprungligen utvecklades för att öka ljusstyrkan på 3D-skärmar, men som länge har använts inofficiellt i 2D-läge, med hjälp av en pulserande panelbakgrundsbelysning för att minska spökbilder (eller rörelseoskärpa). Naturligtvis blev det intressant om denna teknik används i G-synk.

Nvidia gav ett negativt svar. Även om det skulle vara den idealiska lösningen att använda båda teknikerna samtidigt, resulterar idag stroboskop-bakgrundsbelysning med en variabel uppdateringsfrekvens i flimmer och ljusstyrkaproblem. Att lösa dem är otroligt svårt, eftersom du måste justera ljusstyrkan och spåra pulserna. Som ett resultat måste de två teknologierna nu väljas, även om företaget försöker hitta ett sätt att använda dem samtidigt i framtiden.

Inbyggt G-Sync-modulminne

Som vi redan vet G-synk eliminerar den inkrementella ingångsfördröjningen som är associerad med V-sync, eftersom det inte längre finns ett behov av att vänta på att panelskanningen ska slutföras. Vi märkte dock att modulen G-synk har inbyggt minne. Kan modulen buffra ramar på egen hand? Om så är fallet, hur lång tid tar det för ramen att passera genom den nya kanalen?

Enligt Nvidia är ramar inte buffrade i modulens minne. När data kommer in visas den på skärmen och minnet utför några andra funktioner. Dock handläggningstiden för G-synk märkbart mindre än en millisekund. Faktum är att nästan samma fördröjning som vi upplever när V-sync är avstängd, och det är relaterat till funktionerna i spelet, videodrivrutinen, musen etc.

Kommer G-Sync att standardiseras?

En sådan fråga ställdes nyligen i en intervju med AMD, när en läsare ville veta företagets reaktion på tekniken. G-synk. Vi ville dock fråga utvecklaren direkt och se om Nvidia planerar att föra tekniken till branschstandard. I teorin kan ett företag erbjuda G-synk som en uppgradering till DisplayPort-standarden, som ger varierande uppdateringsfrekvenser. Nvidia är trots allt medlem i VESA-föreningen.

Inga nya specifikationer för DisplayPort, HDMI eller DVI är dock planerade. G-synk och så den stöder DisplayPort 1.2, det vill säga standarden behöver inte ändras.

Som nämnts arbetar Nvidia på kompatibilitet G-synk med en teknik som för närvarande heter 3D LightBoost (men kommer snart att få ett annat namn). Dessutom letar företaget efter ett sätt att minska kostnaderna för moduler G-synk och göra dem mer tillgängliga.

G-Sync med Ultra HD-upplösningar

Nvidia lovar skärmar med stöd G-synk och upplösningar upp till 3840x2160 pixlar. Modellen från Asus, som vi ska granska idag, stöder dock bara 1920x1080 pixlar. Ultra HD-skärmar använder för närvarande STMicro Athena-kontrollern, som har två skalare för att skapa en sida vid sida. Vi undrar om modulen G-synk stöder MST-konfiguration?

Sanningen att säga kommer 4K-skärmar med varierande bildhastigheter att få vänta. Det finns ingen separat 4K-uppskalningsenhet ännu, den närmaste bör dyka upp under första kvartalet 2014, och monitorer utrustade med dem - bara under andra kvartalet. Sedan modulen G-synk ersätter zoomenheten, kommer kompatibla paneler att börja visas efter denna punkt. Lyckligtvis har modulen inbyggt stöd för Ultra HD.

Vad händer före 30 Hz?

G-synk kan ändra skärmens uppdateringsfrekvens upp till 30 Hz. Detta förklaras av det faktum att vid mycket låga skärmuppdateringshastigheter börjar bilden på LCD-skärmen försämras, vilket leder till uppkomsten av visuella artefakter. Om källan ger mindre än 30 FPS kommer modulen att uppdatera panelen automatiskt, vilket undviker eventuella problem. Det betyder att en bild kan spelas upp mer än en gång, men den lägre tröskeln är 30 Hz, vilket ger den högsta bildkvaliteten.

G-Sync teknik översikt | 60Hz paneler, SLI, Surround och Tillgänglighet

Är tekniken begränsad till paneler med hög uppdateringsfrekvens?

Du kommer att märka att den första bildskärmen med G-synk den har initialt en mycket hög skärmuppdateringsfrekvens (över den nivå som tekniken kräver) och en upplösning på 1920x1080 pixlar. Men Asus-skärmen har sina egna begränsningar, till exempel en 6-bitars TN-panel. Vi blev nyfikna, introduktionen av teknik G-synkär det bara planerat för skärmar med hög uppdateringsfrekvens eller kommer vi att se det på de vanligare 60hz-skärmarna? Dessutom vill jag få tillgång till en upplösning på 2560x1440 pixlar så snabbt som möjligt.

Nvidia upprepade att den bästa upplevelsen från G-synk kan erhållas när ditt grafikkort håller bildhastigheten inom 30 - 60 FPS. Således kan tekniken verkligen dra nytta av konventionella monitorer med en frekvens på 60 Hz och en modul G-synk .

Men varför använda en 144Hz-skärm då? Det verkar som att många bildskärmstillverkare har bestämt sig för att implementera en funktion med låg rörelseoskärpa (3D LightBoost) som kräver en hög uppdateringsfrekvens. Men de som bestämmer sig för att inte använda den här funktionen (och varför inte, eftersom den ännu inte är kompatibel med G-synk) kan skapa en panel med G-synk för mycket mindre pengar.

På tal om upplösningar, så ser det ut så här: QHD-skärmar med en uppdateringsfrekvens på mer än 120Hz kan börja levereras redan i början av 2014.

Finns det problem med SLI och G-Sync?

Vad krävs för att se G-Sync i surroundläge?

Nu behöver du förstås inte kombinera två grafikadaptrar för att visa en bild i 1080p-kvalitet. Även ett mellanklassbaserat Kepler-grafikkort kommer att kunna ge den prestandanivå som krävs för att spela bekvämt med denna upplösning. Men det finns heller inget sätt att köra två kort i SLI på tre G-synk bildskärmar i surroundläge.

Denna begränsning beror på moderna skärmutgångar på Nvidia-kort, som vanligtvis har två DVI-portar, en HDMI och en DisplayPort. G-synk kräver DisplayPort 1.2 och adaptern fungerar inte (inte heller en MST-hubb). Enda alternativet är att koppla tre bildskärmar i surroundläge till tre kort, d.v.s. Det finns ett separat kort för varje bildskärm. Naturligtvis antar vi att Nvidia-partners kommer att börja släppa "G-Sync Edition"-kort med fler DisplayPort-kontakter.

G-Sync och trippelbuffring

Aktiv trippelbuffring krävdes för att spela bekvämt med v-sync. Behövs hon för G-synk? Svaret är nej. G-synk inte bara kräver det inte trippelbuffring, eftersom kanalen aldrig slutar, det skadar tvärtom G-synk, eftersom det lägger till en extra fördröjningsram utan prestandaförstärkning. Tyvärr ställs speltrippelbuffring ofta in på egen hand och kan inte förbigås manuellt.

Hur är det med spel som vanligtvis reagerar dåligt när V-sync är inaktiverat?

Spel som Skyrim, som är en del av vår testsvit, är designade för att köras med V-sync på en 60Hz-panel (även om detta gör livet svårt för oss ibland på grund av ingångsfördröjning). För att testa dem krävs modifiering av vissa filer med tillägget .ini. Som den beter sig G-synk med spel baserade på Gamebryo och Creation-motorer som är känsliga för vertikala synkroniseringsinställningar? Är de begränsade till 60 FPS?

För det andra behöver du en bildskärm med en Nvidia-modul G-synk. Denna modul ersätter skärmskalaren. Och, till exempel, lägg till den delade Ultra HD-skärmen G-synk omöjlig. I dagens recension använder vi en prototyp med en upplösning på 1920x1080 pixlar och en uppdateringsfrekvens på upp till 144Hz. Men även med det kan du få en uppfattning om vilken inverkan som kommer att få G-synk om tillverkarna börjar installera det i billigare paneler vid 60 Hz.

För det tredje krävs en DisplayPort 1.2-kabel. DVI och HDMI stöds inte. På kort sikt innebär detta att det enda alternativet att arbeta G-synk på tre bildskärmar i surroundläge är det deras anslutning via en trippel SLI-bunt, eftersom varje kort bara har en DisplayPort-kontakt, och adaptrar för DVI till DisplayPort fungerar inte i det här fallet. Detsamma gäller MST-hubbar.

Och slutligen, glöm inte förarstödet. Den senaste paketversionen 331.93 beta är redan kompatibel med G-synk, och vi räknar med att framtida WHQL-certifierade versioner också kommer att innehålla det.

Testbänk

| Testa bänkkonfiguration | |

| CPU | Intel Core i7-3970X (Sandy Bridge-E), 3,5 GHz basklocka, 4,3 GHz överklocka, LGA 2011, 15 MB delad L3-cache, Hyper-Threading aktiverad, energisparfunktioner aktiverade. |

| Moderkort | MSI X79A-GD45 Plus (LGA 2011) X79 Express Chipset, BIOS 17.5 |

| Bagge | G.Skill 32GB (8 x 4GB) DDR3-2133, F3-17000CL9Q-16GBXM x2 @ 9-11-10-28 & 1,65V |

| Lagringsenhet | Samsung 840 Pro SSD 256GB SATA 6Gb/s |

| Grafikkort | Nvidia GeForce GTX 780 Ti 3 GB Nvidia GeForce GTX 760 2 GB |

| kraftenhet | Corsair AX860i 860W |

| Systemprogramvara och drivrutiner | |

| OS | Windows 8 Professional 64-bitars |

| DirectX | DirectX 11 |

| Video drivrutin | Nvidia GeForce 331.93 Beta |

Nu måste vi ta reda på i vilka fall G-synk har störst inverkan. Chansen är stor att du redan använder en bildskärm med en uppdateringsfrekvens på 60Hz. Bland spelare är 120 och 144 Hz modeller mer populära, men Nvidia antar med rätta att majoriteten av entusiaster på marknaden fortfarande kommer att hålla sig till 60 Hz.

Med V-sync aktiv på en 60Hz-skärm visas de mest märkbara artefakterna när kortet inte kan leverera 60fps, vilket resulterar i irriterande hopp mellan 30 och 60 FPS. Det finns märkbara nedgångar här. Med v-sync inaktiverad kommer rivningseffekten att märkas mest i scener där du behöver rotera kameran ofta eller där det är mycket rörelse. För vissa spelare är detta så distraherande att de helt enkelt slår på V-sync och uthärdar stamning och inmatningsfördröjning.

Med uppdateringsfrekvenser på 120 och 144 Hz och högre bildfrekvenser uppdateras skärmen oftare, vilket minskar den tid en enskild bildruta kvarstår över flera skärmskanningar när prestandan är dålig. Problem med aktiv och inaktiv vertikal synkronisering kvarstår dock. Av denna anledning kommer vi att testa Asus-skärmen i 60 och 144 Hz-läge med teknik på och av. G-synk .

G-Sync teknik översikt | Testar G-Sync med V-Sync aktiverat

Det är dags att börja testa G-synk. Det återstår bara att installera ett videoinspelningskort, en uppsättning av flera SSD:er och gå vidare till testerna, eller hur?

Nej, det är fel.

Idag mäter vi inte prestanda, utan kvalitet. I vårt fall kan testerna bara visa en sak: bildhastigheten vid en viss tidpunkt. Om kvaliteten och upplevelsen av användning med tekniken på och av G-synk de säger absolut ingenting. Därför måste vi förlita oss på vår noggrant verifierade och vältaliga beskrivning, som vi kommer att försöka föra så nära verkligheten som möjligt.

Varför inte bara spela in en video och ge den till läsarna att bedöma? Faktum är att kameran spelar in video med en fast hastighet på 60 Hz. Din bildskärm spelar också upp video med en konstant 60Hz uppdateringsfrekvens. Eftersom den G-synk introducerar en variabel uppdateringsfrekvens, kommer du inte att se tekniken i aktion.

Med tanke på antalet tillgängliga spel är antalet möjliga testkombinationer otaliga. V-synk på, V-synk av, G-synk på, G-synk av, 60Hz, 120Hz, 144Hz, ... Listan fortsätter och fortsätter. Men vi börjar med en 60Hz uppdateringsfrekvens och aktiv vsync.

Det är förmodligen enklast att börja med Nvidias egna demoverktyg, som svänger pendeln från sida till sida. Verktyget kan simulera en bildhastighet på 60, 50 eller 40 FPS. Eller så kan frekvensen variera mellan 40 och 60 FPS. Du kan sedan inaktivera eller aktivera V-sync och G-synk. Även om testet är fiktivt, demonstrerar det teknikens kapacitet väl. Du kan titta på en scen med 50 FPS med vsync påslagen och tänka: "Allt är ganska bra, och synlig stamning kan tolereras." Men efter aktivering G-synk Jag vill genast säga: "Vad tänkte jag på? Skillnaden är uppenbar, som dag och natt. Hur kunde jag leva med det här förut?"

Men låt oss inte glömma att detta är en teknisk demo. Jag skulle vilja ha bevis baserade på riktiga spel. För att göra detta måste du köra ett spel med höga systemkrav, som Arma III.

I Arma III kan installeras i en testmaskin GeForce GTX 770 och ställ in ultrainställningar. Med V-sync inaktiverad, fluktuerar bildhastigheten mellan 40 och 50 FPS. Men om du aktiverar V-sync sjunker den till 30 FPS. Prestandan är inte tillräckligt hög för att se konstanta fluktuationer mellan 30 och 60 FPS. Istället minskar helt enkelt grafikkortets bildhastighet.

Eftersom det inte fanns någon bildfrysning var det en signifikant skillnad vid aktivering G-synk inte märkbart, förutom att den faktiska bildhastigheten hoppar 10 - 20 FPS högre. Inmatningsfördröjning bör också minskas, eftersom samma bildruta inte hålls över flera bildskärmsskanningar. Vi upplever att Arma generellt sett är mindre "ryckig" än många andra spel, så du känner ingen eftersläpning.

Å andra sidan, i Metro: Last Light, påverkan G-synk mer artikulerad. Med grafikkort GeForce GTX 770 spelet kan köras i 1920x1080 upplösning med mycket höga detaljinställningar inklusive 16x AF, normal tessellation och rörelseoskärpa. I det här fallet kan du välja SSAA-alternativ från 1x till 2x till 3x för att gradvis minska bildfrekvensen.

Dessutom innehåller spelets miljö en förkammare där det är lätt att skjuta fram och tillbaka. När vi körde nivån med V-sync aktiv vid 60 Hz, gick vi in i staden. Fraps visade att med trippel SSAA var bildhastigheten 30 FPS, och med kantutjämning avstängd var det 60 FPS. I det första fallet märks avmattningar och förseningar. Med SSAA inaktiverat får du en helt jämn bild vid 60 FPS. Aktivering av 2x SSAA orsakar dock fluktuationer från 60 till 30 FPS, från vilka varje duplicerad bildruta skapar en olägenhet. Det här är ett av spelen där vi definitivt skulle stänga av v-sync och bara strunta i att riva. Många människor har redan utvecklat en vana.

dock G-synk tar bort alla negativa effekter. Du behöver inte längre titta på Fraps-räknaren och vänta på fall under 60 FPS för att sänka ytterligare en grafisk inställning. Tvärtom kan du öka en del av dem, för även om du saktar ner till 50 - 40 FPS så blir det inga uppenbara nedgångar. Vad händer om du stänger av vertikal synkronisering? Du kommer att lära dig om detta senare.

G-Sync teknik översikt | Testar G-Sync med V-Sync inaktiverat

Slutsatserna i den här artikeln är baserade på en undersökning av författare och vänner till Tom's Hardware på Skype (med andra ord, urvalet av respondenter är litet), men nästan alla av dem förstår vad vertikal synkronisering är och vilka nackdelar användare har att ställa upp på. Enligt dem tar de till V-sync endast när tårar på grund av en mycket stor spridning i bildhastighet och bildskärmsuppdateringsfrekvens blir outhärdliga.

Som du kan föreställa dig är den visuella effekten av att stänga av Vsync svår att förväxla, även om detta i hög grad påverkas av det specifika spelet och dess detaljinställningar.

Ta till exempel Crysis 3. Spelet kan enkelt få ditt grafikundersystem på knä på de högsta grafikinställningarna. Och eftersom Crysis 3är ett first-person shooter med mycket dynamiskt spel, kan luckorna vara ganska märkbara. I exemplet ovan fångades FCAT-utgången mellan två bildrutor. Som du kan se är trädet helt kapat.

Å andra sidan, när vi tvingar av vsync i Skyrim, är rivningen inte så illa. Observera att i det här fallet är bildhastigheten mycket hög och flera bildrutor visas på skärmen vid varje skanning. Så recensioner, antalet rörelser per bildruta är relativt lågt. Det finns problem när man spelar Skyrim i den här konfigurationen, och det kanske inte är den mest optimala. Men det visar att även med v-sync avstängd kan känslan av spelet förändras.

Som ett tredje exempel valde vi en bild på Lara Crofts axel från Tomb Raider, som visar en ganska tydlig reva i bilden (titta även på håret och remmen på linne). Tomb Raider är det enda spelet i vårt exempel som låter dig välja mellan dubbel- och trippelbuffring när vsync är aktiverat.

Den sista grafen visar att Metro: Last Light med G-synk vid 144Hz ger i allmänhet samma prestanda som med Vsync inaktiverad. Grafen visar dock inte frånvaron av luckor. Om du använder teknik med en 60 Hz-skärm kommer bildhastigheten att nå 60 FPS, men det blir inga nedgångar eller förseningar.

I vilket fall som helst, de av er (och vi) som har spenderat otaliga timmar på grafiska riktmärken och tittat på samma riktmärke om och om igen, skulle kunna vänja sig vid dem och visuellt avgöra hur bra ett visst resultat är. Så här mäter vi grafikkortens absoluta prestanda. Ändringar i bilden med den aktiva G-synk omedelbart fånga ögat, eftersom det finns en jämnhet, som med V-sync påslagen, men utan avbrotten som är karakteristiska för V-sync avstängd. Synd att vi inte kan visa skillnaden i videon just nu.

G-Sync teknik översikt | Spelkompatibilitet: Nästan bra

Kollar andra spel

Vi testade några fler spel. Crysis 3, Tomb Raider, Skyrim, BioShock: Infinite, Battlefield 4 besökte provbänken. Alla, utom Skyrim, har dragit nytta av tekniken G-synk. Effekten berodde på tävlingsspel. Men om du såg honom skulle du genast erkänna att du struntade i de brister som fanns tidigare.

Artefakter kan fortfarande dyka upp. Till exempel är krypeffekten förknippad med kantutjämning mer märkbar med jämna rörelser. Du kommer troligen att vilja ställa in kantutjämningen så högt som möjligt för att ta bort obehagliga stötar som inte var så märkbara tidigare.

Skyrim: Specialfall

Creation-grafikmotorn som Skyrim är baserad på aktiverar vertikal synkronisering som standard. För att testa spelet med en bildhastighet över 60 FPS, lägg till raden iPresentInterval=0 i en av spelets .ini-filer.

Således kan Skyrim testas på tre sätt: i sitt ursprungliga tillstånd, genom att låta Nvidia-drivrutinen "använda programinställningar", aktivera G-synk i drivrutinen och lämna Skyrim-inställningarna intakta och aktivera sedan G-synk och inaktivera V-sync i spelets .ini-fil.

Den första konfigurationen, där den experimentella monitorn är inställd på 60 Hz, visade stabila 60 FPS vid ultrainställningar med ett grafikkort GeForce GTX 770. Följaktligen fick vi en jämn och trevlig bild. Användarens input lider dock fortfarande av latens. Dessutom avslöjade straffen från sida till sida märkbar rörelseoskärpa. Det är dock så de flesta spelar på PC. Naturligtvis kan du köpa en skärm med 144Hz uppdateringsfrekvens och den kommer verkligen att eliminera oskärpa. Men eftersom GeForce GTX 770 ger en uppdateringsfrekvens på runt 90 - 100 fps, kommer det att bli märkbar stamning när motorn fluktuerar mellan 144 och 72 FPS.

Vid 60 Hz G-synk har en negativ effekt på bilden, detta beror troligen på aktiv vertikal synk, trots att tekniken ska fungera med V-sync avstängd. Nu leder lateral strafe (särskilt närmare väggarna) till uttalad inbromsning. Detta är ett potentiellt problem för 60Hz-paneler med G-synk, åtminstone i spel som Skyrim. Lyckligtvis, i fallet med Asus VG248Q-skärmen, kan du byta till 144 Hz-läge, och trots den aktiva V-sync, G-synk kommer att arbeta med denna bildhastighet utan några klagomål.

Att inaktivera vertikal synkronisering helt i Skyrim resulterar i mycket "skarpare" muskontroll. Detta introducerar dock rivning i bilden (för att inte tala om andra artefakter som skimrande vatten). Inkludering G-synk lämnar stamningen vid 60Hz, men vid 144Hz förbättras situationen avsevärt. Även om vi testar spelet med vsync inaktiverat i våra grafikkortsrecensioner, skulle vi inte rekommendera att spela utan det.

För Skyrim skulle kanske den bästa lösningen vara att inaktivera G-synk och spela i 60Hz, vilket ger dig konsekventa 60fps på dina valda grafikinställningar.

G-Sync teknik översikt | G-Sync - vad väntar du på?

Redan innan fick vi ett testprov på en Asus-skärm med teknik G-synk, vi har redan blivit uppmuntrade av det faktum att Nvidia arbetar med ett mycket verkligt problem som påverkar spel som ännu inte har åtgärdats. Fram tills nu har du kunnat slå på eller av V-sync efter eget tycke. Samtidigt åtföljdes alla beslut av kompromisser som påverkar spelupplevelsen negativt. Om du föredrar att inte aktivera v-sync förrän bildrivningen blir outhärdlig, kan vi säga att du väljer det minsta av två onda.

G-synk löser problemet genom att låta monitorn skanna skärmen med en variabel frekvens. Sådan innovation är det enda sättet att fortsätta att utveckla vår bransch samtidigt som den tekniska fördelen med persondatorer bibehålls framför spelkonsoler och plattformar. Nvidia kommer utan tvekan att stå emot kritiken för att inte utveckla en standard som konkurrenterna skulle kunna tillämpa. Däremot använder företaget DisplayPort 1.2 för sin lösning. Som ett resultat, bara två månader efter tillkännagivandet av tekniken G-synk hon var i våra händer.

Frågan är om Nvidia levererar allt det lovade med G-Sync?

Tre begåvade utvecklare som hyllar egenskaperna hos en teknik som du aldrig har sett i aktion kan inspirera någon. Men om din första erfarenhet med G-synk baserat på Nvidias pendeldemo-test kommer du att undra om en sådan enorm skillnad ens är möjlig, eller om testet representerar ett speciellt scenario som är för bra för att vara sant.

Naturligtvis, när man testar tekniken i riktiga spel är effekten inte så entydig. Å ena sidan fanns det utrop av "Wow!" och "Bli galen!", å den andra - "Jag tror jag ser skillnaden." Bästa aktiveringseffekten G-synk märks när du ändrar skärmens uppdateringsfrekvens från 60 Hz till 144 Hz. Men vi försökte också testa på 60Hz med G-synk för att se vad du (förhoppningsvis) får med billigare skärmar i framtiden. I vissa fall kommer det att förvirra dig att bara gå från 60 till 144Hz, speciellt om ditt grafikkort kan hantera höga bildhastigheter.

Idag vet vi att Asus planerar att implementera support för G-synk i modellen Asus VG248QE, som företaget säger kommer att sälja för $400 nästa år. Skärmen har en inbyggd upplösning på 1920x1080 pixlar och en uppdateringsfrekvens på 144Hz. Version utan G-synk har redan fått vårt Smart Buy-pris för enastående prestanda. Men för oss personligen är en 6-bitars TN-panel en nackdel. Jag vill verkligen se 2560x1440 pixlar på en IPS-matris. Vi nöjer oss till och med med en uppdateringsfrekvens på 60 Hz om det hjälper till att hålla priset nere.

Även om vi förväntar oss en hel massa tillkännagivanden på CES, Nvidias officiella kommentarer angående andra skärmar med moduler G-synk och vi har inte hört deras priser. Dessutom är vi inte säkra på vad företagets planer är för en uppgraderingsmodul som ska tillåta dig att implementera modulen. G-synk i en redan köpt bildskärm Asus VG248QE på 20 minuter.

Nu kan vi säga att det är värt att vänta. Du kommer att se att i vissa spel kan effekten av den nya tekniken inte förväxlas, medan den i andra är mindre uttalad. Men ändå G-synk svarar på den "skäggiga" frågan om man ska aktivera eller inte aktivera vertikal synkronisering.

Det finns en annan intressant idé. Efter att vi har testat G-synk, hur länge kommer AMD att kunna undvika kommentarer? Företaget retade våra läsare i sin intervju(engelska), och noterar att hon snart kommer att besluta om denna möjlighet. Tänk om hon har något i åtanke? Slutet av 2013 och början av 2014 ger oss många spännande nyheter att diskutera, bl.a. Battlefield 4 Mantle-versioner, den kommande Nvidia Maxwell-arkitekturen, G-synk, en AMD xDMA-motor med CrossFire-stöd och rykten om nya dual-chip grafikkort. Just nu har vi inte tillräckligt med grafikkort med mer än 3GB (Nvidia) och 4GB (AMD) GDDR5-minne, men de kostar mindre än $1000...

Det finns saker som inte bara är svåra att skriva om, utan väldigt svåra. Som du bara behöver se en gång än höra om dem hundra gånger eller läsa på Internet. Det är till exempel omöjligt att beskriva vissa naturliga underverk, som den majestätiska Grand Canyon eller de snötäckta Altaibergen. Du kan titta på vackra bilder med deras bild hundra gånger och njuta av videorna, men allt detta kommer inte att ersätta liveintryck.

Ämnet mjuk ramutmatning till en bildskärm som använder Nvidia G-Sync-teknik hör också till sådana ämnen - enligt textbeskrivningar verkar förändringarna inte så betydande, men under de allra första minuterna av ett 3D-spel på ett system med en Nvidia Geforce grafikkort kopplat till G-Sync -monitor blir det tydligt hur stort det kvalitativa språnget är. Och även om det har gått mer än ett år sedan tillkännagivandet av tekniken, tappar tekniken inte sin relevans, den har fortfarande inga konkurrenter (bland de lösningar som har kommit in på marknaden), och motsvarande bildskärmar fortsätter att produceras.

Nvidia har arbetat med frågan om att förbättra användarupplevelsen av Geforce-grafikprocessorer i moderna spel genom att förbättra renderingens smidighet under ganska lång tid. Vi kan komma ihåg Adaptive V-Sync adaptiv sync-teknik, som är en hybrid som kombinerar V-sync på och av lägen (V-Sync On och V-Sync Off, respektive). Om grafikprocessorn renderar med en bildhastighet som är lägre än bildskärmens uppdateringsfrekvens, är synkroniseringen inaktiverad och för FPS som överskrider uppdateringsfrekvensen, är den aktiverad.

Fluiditetsproblem löstes inte alla med adaptiv synkronisering, men det var ett viktigt steg i rätt riktning. Men varför var det överhuvudtaget nödvändigt att göra några speciella synkroniseringslägen och till och med släppa mjukvaru- och hårdvarulösningar? Vad är det för fel på teknik som har funnits i decennier? Idag ska vi visa dig hur Nvidias G-Sync-teknik hjälper till att eliminera kända skärmartefakter som rivning, stamning och ökad latens.

När vi blickar framåt kan vi säga att G-Sync-synkroniseringstekniken låter dig få mjuka rambyten med högsta möjliga prestanda och komfort, vilket är mycket märkbart när du spelar på en sådan bildskärm - detta märks även för den genomsnittliga hemanvändaren, och för ivrig spelare kan det innebära en förbättring av reaktionstiden, och samtidigt spelprestationer.

Idag använder de flesta PC-spelare skärmar med en uppdateringsfrekvens på 60Hz – typiska LCD-skärmar är de mest populära just nu. Följaktligen, både när synkronisering är påslagen (V-Sync On) och när den är avstängd, finns det alltid några brister förknippade med de grundläggande problemen med antika teknologier, som vi kommer att diskutera senare: hög latens och FPS-ryck med V-Sync påslagen och obehagliga luckor bilder när av.

Och eftersom förseningarna och ojämna bildhastigheter är mer irriterande och irriterande, slår sällan någon av spelarna på synkroniseringen alls. Och även vissa modeller av bildskärmar med en uppdateringsfrekvens på 120 och 144 Hz som har dykt upp på marknaden kan inte hjälpa till att eliminera problem helt, de gör dem helt enkelt något mindre märkbara genom att uppdatera skärmens innehåll dubbelt så ofta, men samma artefakter finns fortfarande kvar : laggar och frånvaron av samma bekväma jämnhet.

Och eftersom G-Sync-skärmar parade med ett lämpligt Nvidia Geforce-grafikkort inte bara kan ge en hög uppdateringsfrekvens, utan också eliminera alla dessa brister, kan köp av sådana lösningar anses vara ännu viktigare än att ens uppgradera till en kraftfullare GPU. Men låt oss först förstå varför det var nödvändigt att göra något annat än de sedan länge kända lösningarna - vad är problemet här?

Problem med befintliga videoutgångsmetoder

Teknologier för att visa bilder på en skärm med en fast uppdateringsfrekvens har funnits sedan de dagar då katodstrålerör (CRT) monitorer användes. De flesta läsare borde komma ihåg dem - grymma sådana, som gamla tv-apparater. Dessa tekniker utvecklades ursprungligen för att visa tv-bilder med en fast bildhastighet, men när det gäller enheter för att mata ut 3D-bilder dynamiskt beräknade på en PC, orsakar denna lösning stora problem som hittills inte har lösts.

Även de modernaste LCD-skärmarna har en fast bilduppdateringsfrekvens på skärmen, även om tekniskt sett ingenting hindrar dem från att ändra bilden när som helst, vid vilken frekvens som helst (inom rimliga gränser förstås). Men PC-spelare från gamla dagar med CRT-skärmar måste stå ut med en bestämt ofullständig lösning på problemet med att synkronisera bildhastighet för 3D-rendering och bildskärmsuppdateringsfrekvens. Hittills har det funnits väldigt få alternativ för att visa en bild - två, och båda har nackdelar.

Roten till alla problem ligger i det faktum att med en fast uppdateringsfrekvens för bilden på monitorn, återger grafikkortet varje bildruta vid en annan tidpunkt - detta händer på grund av scenens ständigt föränderliga komplexitet och belastningen på grafiken processor. Och renderingstiden för varje bildruta är inte konstant, den ändrar varje bildruta. Det är inte konstigt att när man försöker visa ett antal ramar på bildskärmen uppstår synkroniseringsproblem, eftersom vissa av dem kräver mycket mer tid att rita än andra. Som ett resultat får vi olika förberedelsetider för varje bildruta: ibland 10 ms, ibland 25 ms, till exempel. Och monitorerna som fanns innan G-Sync kom kunde bara visa bildrutor efter en viss tidsperiod – inte tidigare, inte senare.

Saken kompliceras ytterligare av rikedomen av hårdvaru- och mjukvarukonfigurationer för speldatorer, i kombination med mycket olika belastning beroende på spel, kvalitetsinställningar, videodrivrutininställningar etc. Som ett resultat är det omöjligt att konfigurera varje spelsystem så att personalutbildning genomförs med konstanta eller åtminstone inte alltför olika tider i alla 3D-applikationer och förhållanden - vilket är möjligt på spelkonsoler med sin enda hårdvarukonfiguration.

Naturligtvis, till skillnad från konsoler med sina förutsägbara bildåtergivningstider, är PC-spelare fortfarande starkt begränsade i sin förmåga att uppnå en smidig spelupplevelse utan märkbara neddragningar och fördröjningar. I det ideala (läs - omöjligt i verkligheten) fallet bör uppdateringen av bilden på skärmen utföras strikt efter att nästa bildruta beräknas och förbereds av GPU:

Som du kan se, i det här hypotetiska exemplet har GPU:n alltid tid att rita en ram innan den behöver överföras till monitorn - bildrutetiden är alltid något mindre än tiden mellan uppdateringar av information på skärmen och i bryter GPU:n vilar lite. Men i verkligheten är allt helt annorlunda - bildåtergivningstiden är väldigt annorlunda. Föreställ dig om GPU:n inte har tid att rendera en bildruta inom den tilldelade tiden - då måste ramen antingen visas senare, hoppa över en uppdatering av bilden på skärmen (vertikal synkronisering är aktiverad - V-Sync On), eller visa ramar i delar med synkronisering inaktiverad, och sedan på monitorn samtidigt kommer det att finnas bitar från flera intilliggande ramar.

De flesta användare stänger av V-Sync för att få lägre latens och jämnare skärmutdata, men den här lösningen introducerar synliga rivningsartefakter. Och med synkronisering påslagen blir det ingen bildrivning, eftersom ramar visas uteslutande i sin helhet, men fördröjningen mellan spelarens handling och uppdatering av bilden på skärmen ökar, och bildhastigheten är mycket ojämn, eftersom GPU:n aldrig ritar ramar strikt i enlighet med uppdateringstiden för bilden på monitorn.

Detta problem har funnits i många år och stör uppenbarligen bekvämligheten med att se resultatet av en 3D-rendering, men fram till en tid brydde sig ingen om att lösa det. Och lösningen, i teorin, är ganska enkel - du behöver bara visa information på skärmen strikt när GPU:n slutar arbeta på nästa bildruta. Men först, låt oss ta en närmare titt på exempel på hur befintliga bildutmatningstekniker fungerar, och vilken lösning Nvidia erbjuder oss i sin G-Sync-teknik.

Nackdelar med utgång när synkronisering är inaktiverad

Som vi redan nämnt föredrar de allra flesta spelare att hålla synkroniseringen avstängd (V-Sync Off) för att få visningen av ramar som renderas av GPU:n på skärmen så snabbt som möjligt och med minsta möjliga fördröjning mellan spelarens handlingar (tangenttryckningar, muskommandon) och deras visning. För seriösa spelare är detta nödvändigt för segrar, och för vanliga spelare, i det här fallet, kommer sensationerna att vara trevligare. Så här ser det schematiskt ut att arbeta med V-Sync inaktiverad:

Det finns inga problem och förseningar med indragningen av ramar. Men även om den inaktiverade vsync löser problemet med fördröjning så mycket som möjligt och ger en minimal fördröjning, visas samtidigt artefakter på bilden - bilden går sönder när bilden på skärmen består av flera bitar av intilliggande ramar som återges av GPU:n. Bristen på jämnhet i videosekvensen märks också på grund av ojämnheten i ramarna som kommer från GPU:n till skärmen - bildbrott på olika ställen.

Dessa rivningar är resultatet av att visa två av de fler bildrutorna som återges på GPU:n under en bildskärmsuppdateringscykel. Av flera - när bildfrekvensen överstiger bildskärmens uppdateringsfrekvens, och av de två - när den ungefär motsvarar den. Titta på diagrammet ovan - om innehållet i rambufferten uppdateras i mitten mellan tiderna för visning av information på monitorn, så kommer den slutliga bilden på den att förvrängas - i det här fallet tillhör en del av informationen den föregående ram, och resten till den nuvarande som ritas.

Med synkronisering inaktiverad skickas ramar till monitorn utan hänsyn till dess uppdateringsfrekvens eller tid, så de matchar aldrig monitorns uppdateringsfrekvens. Med andra ord, med V-Sync avstängd, kommer bildskärmar utan G-Sync-stöd alltid att uppleva sådana rivningar i bilden.

Det handlar inte bara om det faktum att det är obehagligt för spelaren att se ränder som rycker över hela skärmen, utan också att den samtidiga återgivningen av delar av olika bildrutor kan felinformera hjärnan, vilket är särskilt märkbart med dynamiska objekt i bilden - spelaren ser delar av objekt förskjutna i förhållande till varandra. Du måste stå ut med detta bara för att inaktivera V-Sync ger minimal utmatningsfördröjning för tillfället, men långt ifrån idealisk dynamisk bildkvalitet, som du kan se i följande exempel (ramar med full upplösning är tillgängliga genom att klicka):

Med hjälp av exemplen ovan, tagna med FCAT-programvaran och hårdvarusystemet, kan du se till att den verkliga bilden på skärmen kan bestå av delar av flera intilliggande ramar - och ibland ojämnt, när en smal remsa tas från en av ramar, och de intilliggande upptar resten (märkbart större) del av skärmen.

Rivningsproblem är ännu mer synliga i dynamiken (om ditt system och/eller webbläsare inte stöder uppspelning av MP4/H.264-videor med en upplösning på 1920 × 1080 pixlar med en uppdateringshastighet på 60 FPS, måste du ladda ner och visa dem lokalt med hjälp av en mediaspelare med relevanta funktioner):

Som du kan se, även i dynamik, är obehagliga artefakter i form av bildavbrott lätt märkbara. Låt oss se hur det ser ut schematiskt - i ett diagram som visar utdatametoden med synkronisering inaktiverad. I det här fallet kommer ramarna till bildskärmen omedelbart efter att GPU:n har slutfört att rendera dem, och bilden visas på skärmen även om utmatningen av information från den aktuella bildrutan ännu inte har slutförts helt - resten av bufferten faller på nästa skärmuppdatering. Det är därför varje bildruta i vårt exempel som visas på skärmen består av två ramar ritade på GPU:n - med en bildbrytning på den plats som är markerad i rött.

I det här exemplet renderas den första bildrutan (Draw 1) av grafikprocessorn till skärmbufferten snabbare än dess uppdateringstid på 16,7 ms - och innan bilden renderas till monitorn (Skanna 0/1). GPU:n börjar omedelbart arbeta på nästa bildruta (Draw 2), vilket bryter bilden på bildskärmen, som innehåller ytterligare hälften av föregående bildruta.

Som ett resultat, i många fall, visas ett tydligt urskiljbart band på bilden - gränsen mellan den partiella visningen av intilliggande ramar. I framtiden upprepas denna process, eftersom GPU:n fungerar på varje bildruta under en annan tidsperiod, och utan processsynkronisering matchar ramarna från GPU:n och de som visas på bildskärmen aldrig.

För- och nackdelar med vertikal synkronisering

När du slår på den traditionella vertikala synkroniseringen (V-Sync On), uppdateras informationen på bildskärmen först när arbetet med ramen är helt klart av grafikprocessorn, vilket eliminerar riva i bilden, eftersom ramarna visas helt och hållet på skärmen. Men eftersom bildskärmen uppdaterar innehållet endast med vissa intervall (beroende på egenskaperna hos utenheten), medför denna bindning andra problem.

De flesta moderna LCD-skärmar uppdaterar information med en frekvens på 60 Hz, det vill säga 60 gånger per sekund - ungefär var 16:e millisekund. Och med synkronisering aktiverad är bildutgångstiden tätt bunden till monitorns uppdateringsfrekvens. Men, som vi vet, är GPU-bildhastigheten alltid variabel, och renderingstiden för varje bildruta skiljer sig beroende på den ständigt föränderliga komplexiteten i 3D-scenen och kvalitetsinställningar.

Det kan inte alltid vara lika med 16,7 ms, men kommer att vara antingen mindre än detta värde eller mer. Med synkronisering aktiverad slutförs GPU:ns arbete med ramar igen antingen tidigare eller senare än skärmens uppdateringstid. Om ramen renderades snabbare än detta ögonblick, finns det inga speciella problem - visuell information väntar helt enkelt på att skärmens uppdateringstid ska visa ramen på skärmen i sin helhet, och GPU:n är inaktiv. Men om ramen inte har tid att rendera inom den tilldelade tiden, måste den vänta på nästa cykel för att uppdatera bilden på monitorn, vilket orsakar en ökning av fördröjningen mellan spelarens handlingar och deras visuella visning på skärmen . Samtidigt visas bilden av den tidigare "gamla" ramen igen på skärmen.

Även om allt detta händer ganska snabbt, men ökningen i latens är visuellt lätt märkbar, och inte bara av professionella spelare. Och eftersom bildåtergivningstiden alltid är variabel, orsakar ett ryck vid visning av en dynamisk bild om du slår på bindningen till bildskärmens uppdateringsfrekvens, eftersom bildrutorna antingen visas snabbt (lika med bildskärmens uppdateringsfrekvens) eller två gånger, tre gånger, fyra gånger gånger långsammare. Betrakta ett schematiskt exempel på sådant arbete:

Illustrationen visar hur ramar visas på monitorn när vertikal synk är på (V-Sync On). Den första bildrutan (Draw 1) renderas av GPU:n snabbare än 16,7 ms, så GPU:n går inte vidare för att arbeta med att rendera nästa bildruta och river inte sönder bilden, som i fallet med V-Sync Off, men väntar på att den första bilden ska visas helt på monitorn. Och först efter det börjar den rita nästa ram (Rita 2).

Men arbetet med den andra bildrutan (Draw 2) tar mer tid än 16,7 ms, så efter att de löper ut visas visuell information från föregående bild på skärmen och den visas på skärmen i ytterligare 16,7 ms. Och även efter att grafikprocessorn har slutat arbeta med nästa bildruta, visas den inte på skärmen, eftersom bildskärmen har en fast uppdateringsfrekvens. I allmänhet måste du vänta 33,3 ms på att den andra bildrutan ska visas, och all denna tid läggs till fördröjningen mellan spelarens handling och slutet av bildrutan som visas på monitorn.

Till problemet med tidsfördröjningen finns det också en lucka i videosekvensens mjukhet, märkbar av ryckigheten i 3D-animationen. Problemet visas mycket tydligt i en kort video:

Men även de mest kraftfulla grafikprocessorerna i krävande moderna spel kan inte alltid ge en tillräckligt hög bildfrekvens som överstiger den typiska bildskärmens uppdateringsfrekvens på 60 Hz. Och följaktligen kommer de inte att ge möjligheten till ett bekvämt spel med synkroniseringen påslagen och frånvaron av problem som att riva bilden. Speciellt när det kommer till spel som multiplayern Battlefield 4, mycket krävande Far Cry 4 och Assassin's Creed Unity med höga upplösningar och maximala spelinställningar.

Det vill säga, den moderna spelaren har lite val - antingen få en brist på jämnhet och ökade förseningar, eller nöja sig med ofullständig bildkvalitet med trasiga bitar av ramar. Visst, i verkligheten ser allt inte så illa ut, för på något sätt har vi spelat hela den här tiden, eller hur? Men i tider när de försöker uppnå idealet både vad gäller kvalitet och komfort, vill du ha mer. LCD-skärmar har dessutom en grundläggande teknisk förmåga att visa ramar när grafikprocessorn indikerar det. Poängen är liten - att ansluta GPU:n och bildskärmen, och det finns redan en sådan lösning - Nvidia G-Sync-teknik.

G-Sync-teknik - Nvidias lösning på prestandaproblem

Så de flesta moderna spel i versionen med synkronisering avstängd orsakar bildavbrott, och med den påslagen, ojämna ramförändringar och ökade förseningar. Även vid höga uppdateringsfrekvenser kan traditionella bildskärmar inte bli av med dessa problem. Förmodligen har valet mellan två långt ifrån idealiska alternativ för att visa ramar i 3D-applikationer genom åren stört Nvidia-anställda så mycket att de bestämde sig för att bli av med problemen genom att ge spelare ett fundamentalt nytt tillvägagångssätt för att uppdatera information på skärmen.

Skillnaden mellan G-Sync-teknik och befintliga visningsmetoder är att tiden och bildhastigheten i fallet med Nvidia-varianten bestäms av Geforce GPU, och den förändras dynamiskt, inte fixerad, som den var tidigare. Med andra ord, i det här fallet tar GPU:n full kontroll över ramutgången - så fort den är klar med nästa bildruta visas den på skärmen, utan förseningar och bildavbrott.

Att använda den här typen av anslutning mellan GPU:n och den specialanpassade bildskärmshårdvaran ger spelarna den bästa utdatametoden - helt perfekt, vad gäller kvalitet, vilket eliminerar alla problem vi nämnde ovan. G-Sync ger en perfekt jämn bildändring på monitorn, utan några förseningar, ryck och artefakter som orsakas av visningen av visuell information på skärmen.

Naturligtvis fungerar inte G-Sync magiskt, och för att tekniken ska fungera på bildskärmssidan krävs tillägg av speciell hårdvarulogik i form av ett litet kort levererat av Nvidia.

Företaget samarbetar med bildskärmstillverkare för att inkludera G-Sync-kort i sina spelskärmsmodeller. För vissa modeller finns det till och med ett uppgraderingsalternativ av användaren själv, men det här alternativet är dyrare, och det är inte vettigt, eftersom det är lättare att omedelbart köpa en G-Sync-skärm. Från en PC räcker det att ha något av de moderna Nvidia Geforce-grafikkorten i sin konfiguration, såväl som en installerad G-Sync-optimerad videodrivrutin - någon av de senaste versionerna kommer att göra det.

När Nvidia G-Sync-teknik är aktiverad, efter att ha bearbetat nästa bildruta i 3D-scenen, skickar Geforce GPU en speciell signal till G-Sync-kontrollkortet som är inbyggt i monitorn, som talar om för monitorn när bilden ska uppdateras på skärmen . Detta gör att du kan uppnå perfekt jämnhet och lyhördhet när du spelar på en PC - du kan se detta genom att titta på en kort video (krävs med 60 bilder per sekund!):

Låt oss se hur konfigurationen med aktiverad G-Sync-teknik ser ut, enligt vårt schema:

Som du kan se är allt väldigt enkelt. Aktivering av G-Sync binder bildskärmens uppdateringsfrekvens till slutet av renderingen av varje bildruta på GPU:n. GPU:n har full kontroll över arbetet: så snart den är klar med att rendera ramen visas bilden omedelbart på en G-Sync-kompatibel bildskärm, och som ett resultat är skärmens uppdateringshastighet inte fast, utan variabel - exakt som GPU-bildhastigheten. Detta eliminerar problem med bildrivning (eftersom den alltid innehåller information från en enda bildruta), minimerar jitter i bildhastighet (skärmen väntar inte längre än en bildruta fysiskt bearbetas av GPU) och minskar utmatningsfördröjningen i förhållande till vsync- aktiverad metod.

Jag måste säga att spelarna uppenbarligen saknade en sådan lösning, den nya metoden att synkronisera GPU:n och Nvidia G-Sync-skärmen har verkligen en mycket stark effekt på bekvämligheten att spela på en PC - den väldigt nästan perfekta jämnheten visas, vilket var inte där förrän nu - i vår tid med superkraftiga grafikkort! Sedan tillkännagivandet av G-Sync-tekniken har de gamla metoderna omedelbart blivit en anakronism och uppgradering till en G-Sync-monitor som kan variera uppdateringshastigheter upp till 144 Hz verkar vara ett mycket attraktivt alternativ för att äntligen bli av med problem, fördröjningar och artefakter .

Har G-Sync nackdelar? Naturligtvis, som vilken teknik som helst. Till exempel har G-Sync en irriterande begränsning, som är att den ger en jämn bildruta till skärmen med en frekvens på 30 FPS. Och den valda uppdateringsfrekvensen för monitorn i G-Sync-läge sätter ribban för hastigheten för skärmens uppdatering. Det vill säga, med en uppdateringsfrekvens inställd på 60 Hz, kommer maximal jämnhet att tillhandahållas vid en frekvens på 30-60 FPS och vid 144 Hz - från 30 till 144 FPS, men inte mindre än den nedre gränsen. Och med en variabel frekvens (till exempel från 20 till 40 FPS) kommer resultatet inte längre att vara idealiskt, även om det är märkbart bättre än traditionell V-Sync.

Men den största nackdelen med G-Sync är att det är Nvidias egenutvecklade teknologi som konkurrenterna inte har tillgång till. Därför tillkännagav AMD i början av det utgående året en liknande FreeSync-teknologi, som också består i att dynamiskt ändra bildskärmens bildhastighet i enlighet med förberedelsen av ramar från GPU:n. En viktig skillnad är att AMD-utvecklingen är öppen och inte kräver ytterligare hårdvarulösningar i form av specialiserade bildskärmar, eftersom FreeSync har förvandlats till Adaptive-Sync, som har blivit en valfri del av DisplayPort 1.2a-standarden från den ökända VESA ( Video Electronics Standards Association). Det visar sig att AMD skickligt kommer att använda temat utvecklat av en konkurrent för sin egen fördel, eftersom utan utseendet och populariseringen av G-Sync, skulle de inte ha haft någon FreeSync, som vi tror.

Intressant nog är Adaptive-Sync-tekniken också en del av VESA-standarden för inbyggd DisplayPort (eDP), och används redan i många bildskärmskomponenter som använder eDP för signalöverföring. En annan skillnad mot G-Sync är att VESA-medlemmar kan använda Adaptive-Sync utan att behöva betala. Det är dock mycket troligt att Nvidia även kommer att stödja Adaptive-Sync i framtiden som en del av DisplayPort 1.2a-standarden, eftersom sådant stöd inte kommer att kräva mycket ansträngning från dem. Men företaget kommer inte heller att tacka nej till G-Sync, eftersom man anser att sina egna lösningar är prioriterade.

De första Adaptive-Sync-aktiverade bildskärmarna bör anlända under första kvartalet 2015, inte bara med DisplayPort 1.2a-portar, utan också med dedikerat Adaptive-Sync-stöd (inte alla DisplayPort 1.2a-aktiverade bildskärmar kommer att kunna skryta med detta). I mars 2015 planerar Samsung således att lansera monitorlinjerna Samsung UD590 (23,6 och 28 tum) och UE850 (23,6, 27 och 31,5 tum) med stöd för UltraHD-upplösning och Adaptive-Sync-teknik. AMD hävdar att bildskärmar med denna teknik kommer att vara upp till 100 $ billigare än liknande enheter med G-Sync-stöd, men det är svårt att jämföra dem, eftersom alla bildskärmar är olika och kommer ut vid olika tidpunkter. Dessutom finns det redan inte så dyra G-Sync-modeller på marknaden.

Visuell skillnad och subjektiva intryck

Ovan beskrev vi teorin, och nu är det dags att visa allt tydligt och beskriva dina känslor. Vi testade Nvidias G-Sync-teknik i praktiken i flera 3D-applikationer med hjälp av ett Inno3D iChill Geforce GTX 780 HerculeZ X3 Ultra-grafikkort och en Asus PG278Q-skärm som stöder G-Sync-teknik. Det finns flera modeller av bildskärmar med G-Sync-stöd på marknaden från olika tillverkare: Asus, Acer, BenQ, AOC och andra, och för Asus VG248QE-skärmen kan du till och med köpa ett kit för att uppgradera den för att stödja G-Sync på din egen.

Den yngsta grafikkortsmodellen som använder G-Sync-teknik är Geforce GTX 650 Ti, med ett extremt viktigt krav på en DisplayPort-kontakt ombord. Andra systemkrav inkluderar minst Microsoft Windows 7 operativsystem, användning av en bra DisplayPort 1.2-kabel och användning av en högkvalitativ mus med hög känslighet och pollinghastighet rekommenderas. G-Sync-tekniken fungerar med alla 3D-applikationer i helskärm som använder OpenGL och Direct3D grafik API:er när de körs på Windows 7 och 8.1 operativsystem.

Alla moderna drivrutiner är lämpliga för arbete, vilket - G-Sync har stötts av alla företagsförare i mer än ett år. Om du har alla nödvändiga komponenter behöver du bara aktivera G-Sync i drivrutinerna, om det inte redan har gjorts, och tekniken kommer att fungera i alla helskärmsapplikationer - och bara i dem, baserat på själva principen av tekniken.

För att aktivera G-Sync-teknik för helskärmsapplikationer och få bästa möjliga upplevelse måste du aktivera 144Hz uppdateringsfrekvens i Nvidias kontrollpanel eller operativsystems skrivbordsinställningar. Sedan måste du se till att användningen av teknik är tillåten på motsvarande sida "Ställa in G-Sync" ...

Och även - välj lämplig post på sidan "Hantera 3D-inställningar" i parametern "Vertikal synkroniseringspuls" för de globala 3D-inställningarna. Där kan du också inaktivera användningen av G-Sync-teknik för teständamål eller om några problem dyker upp (om vi ser framåt - vi hittade inga under vår testning).

G-Sync-tekniken fungerar i alla upplösningar som stöds av bildskärmar, upp till UltraHD, men i vårt fall använde vi en inbyggd upplösning på 2560 × 1440 pixlar vid 144 Hz. I våra jämförelser med det nuvarande tillståndet använde vi ett 60Hz uppdateringsfrekvensläge med G-Sync inaktiverat för att efterlikna beteendet hos typiska icke-G-Sync-skärmar som finns hos de flesta spelare. De flesta av dem använder Full HD-skärmar som klarar av maximalt läge vid 60Hz.

Var noga med att nämna att även om med G-Sync aktiverat kommer skärmuppdateringen att vara vid en idealisk frekvens - när grafikprocessorn "vill ha" det kommer det optimala läget fortfarande att renderas med en bildhastighet på cirka 40-60 FPS - detta är den mest lämpliga bildfrekvensen för moderna spel, inte för liten för att nå den nedre gränsen på 30 FPS, men inte heller kräver en minskning av inställningarna. Förresten, Nvidias Geforce Experience-program strävar efter exakt denna frekvens, och tillhandahåller lämpliga inställningar för populära spel i programvaran med samma namn som följer med drivrutinerna.

Förutom spel testade vi även en specialiserad testapplikation från Nvidia - . Denna applikation visar en 3D-pendelscen som är lätt att bedöma jämnheten och kvaliteten, låter dig simulera olika bildhastigheter och välja visningsläge: V-Sync Off/On och G-Sync. Med denna testmjukvara är det väldigt enkelt att visa skillnaden mellan olika synkroniseringslägen - till exempel mellan V-Sync On och G-Sync:

Pendulum Demo-appen låter dig testa olika synkroniseringsmetoder under olika förhållanden, den simulerar den exakta bildhastigheten på 60 FPS för att jämföra V-Sync och G-Sync under idealiska förhållanden för den äldre synkroniseringsmetoden - i det här läget bör det helt enkelt finnas ingen skillnad mellan metoderna. Men 40-50 FPS-läget sätter V-Sync On i en besvärlig position där fördröjningar och klumpiga bildruteändringar är synliga för blotta ögat, eftersom bildåtergivningstiden överstiger uppdateringsfrekvensen vid 60 Hz. När du slår på G-Sync blir allt perfekt.

När det gäller att jämföra lägen med V-Sync inaktiverat och G-Sync aktiverat, här hjälper Nvidia-applikationen också att se skillnaden - vid bildhastigheter mellan 40 och 60 FPS är bildrivning tydligt synlig, även om det finns mindre fördröjningar än med V- Synkronisera på. Och till och med den icke-släta videosekvensen angående G-Sync-läget är märkbar, även om det i teorin inte borde vara det - kanske är det så här hjärnan uppfattar "slitna" ramar.

Tja, med G-Sync aktiverat ger alla lägen i testapplikationen (konstant bildhastighet eller variabel - det spelar ingen roll) alltid den jämnaste videosekvensen. Ja, och i spel är alla problem med det traditionella tillvägagångssättet för att uppdatera information på en bildskärm med en fast uppdateringsfrekvens ibland märkbara nästan ännu mer - i det här fallet kan du tydligt uppskatta skillnaden mellan alla tre lägena i exemplet med StarCraft II-spel (visar en tidigare sparad inspelning):

Om ditt system och din webbläsare stöder uppspelning av MP4/H.264 videodataformat vid 60 FPS, kommer du tydligt att se att i det inaktiverade synkroniseringsläget märks uppenbara videoavbrott, när V-Sync är aktiverat, ryck och ojämna videosekvenser observeras. Allt detta försvinner när du slår på Nvidia G-Sync, där det inte finns några artefakter i bilden, ingen ökning av fördröjningar, ingen "sliten" bildhastighet.

Naturligtvis är G-Sync inte ett trollspö, och den här tekniken kommer inte att bli av med förseningar och nedgångar som inte orsakas av processen att visa ramar på en bildskärm med en fast uppdateringsfrekvens. Om spelet i sig har problem med jämnheten i frame-output och stora ryck i FPS orsakade av laddning av texturer, bearbetning av data på CPU, suboptimalt arbete med videominne, brist på kodoptimering, etc., så kommer de att förbli på plats. Dessutom kommer de att bli ännu mer märkbara, eftersom utmatningen av de återstående ramarna kommer att vara perfekt jämn. Men i praktiken, på kraftfulla system, uppstår problem inte för ofta, och G-Sync förbättrar verkligen uppfattningen av dynamisk video.

Eftersom Nvidias nya utgångsteknik påverkar hela utgångspipelinen, kan den teoretiskt orsaka artefakter och bildhastighetsvågor, speciellt om spelet artificiellt begränsar FPS någon gång. Förmodligen är sådana fall, om några, så sällsynta att vi inte ens märkte dem. Men de noterade en tydlig förbättring av komforten när man spelar - när man spelar bakom en bildskärm med G-Sync-teknik aktiverad verkar det som om datorn har blivit så kraftfull att den klarar en konstant bildhastighet på minst 60 FPS utan några neddragningar.

Känslan man får när man spelar med en G-Sync-skärm är väldigt svår att beskriva med ord. Skillnaden är särskilt märkbar vid 40-60 FPS – en bildhastighet som är väldigt vanlig i krävande moderna spel. Skillnaden jämfört med konventionella bildskärmar är helt enkelt fantastisk, och vi kommer att försöka inte bara berätta det i ord och visa det i videoexempel, utan också att visa bildhastighetsdiagram erhållna med olika visningslägen.

I spel av genrer som realtidsstrategi och liknande, som StarCraft II, League of Legends, DotA 2, etc., är fördelarna med G-Sync-teknik tydligt synliga, som du kan se från exemplet från videon ovan. Dessutom kräver sådana spel alltid fartfylld action som inte tolererar förseningar och ojämna bildhastigheter, och mjuk rullning spelar en ganska viktig roll för komforten, vilket i hög grad hindras av videorivning med V-Sync Off, fördröjningar och fördröjningar med V -Synkronisera på. Så G-Sync-tekniken är idealisk för dessa typer av spel.

First person shooters som Crysis 3 och Far Cry 4 är ännu vanligare, de är också mycket krävande på datorresurser, och vid högkvalitativa inställningar får spelare i dem ofta en bildhastighet på strax runt 30-60 FPS - perfekt för användning G -Sync, vilket verkligen förbättrar komforten när man spelar under sådana förhållanden. Den traditionella vertikala synkroniseringsmetoden kommer mycket ofta att göra att ramar matas ut med en frekvens på endast 30 FPS, vilket ökar fördröjningar och ryck.

Detsamma gäller tredjepersonsspel som Batman, Assassin's Creed och Tomb Raider. Dessa spel använder också den senaste grafikteknologin och kräver ganska kraftfulla GPU:er för att uppnå höga bildhastigheter. Vid maximala inställningar i dessa spel och avstängning av V-Sync erhålls ofta FPS i storleksordningen 30-90, vilket orsakar obehaglig rivning av bilden. Att aktivera V-Sync hjälper bara i vissa scener med lägre resurskrav, och bildhastigheten hoppar från 30 till 60 i steg, vilket orsakar nedgångar och ryck. Och införandet av G-Sync löser alla dessa problem, och det är mycket märkbart i praktiken.

Öva provresultat

I det här avsnittet ska vi ta en titt på effekten av G-Sync och V-Sync på bildhastigheter - prestandagraferna ger dig en bra uppfattning om hur de olika teknologierna fungerar. Under testet testade vi flera spel, men det är långt ifrån bekvämt för alla att visa skillnaden mellan V-Sync och G-Sync - vissa spelriktmärken tillåter inte att tvinga V-Sync, andra spel har inte ett bekvämt verktyg för att spela den exakta spelsekvensen (de flesta moderna spel, tyvärr), andra kör för snabbt eller inom snäva ramhastighetsgränser på vårt testsystem.

Så vi slutade med Just Cause 2 vid maxinställningar och ett par riktmärken: Unigine Heaven och Unigine Valley - också vid maxkvalitetsinställningar. Bildhastigheten i dessa applikationer varierar ganska mycket, vilket är bekvämt för vårt syfte - att visa vad som händer med utdata från ramar under olika förhållanden.

Tyvärr har vi för tillfället inte FCAT-hårdvaru- och mjukvarusystemet i bruk, och vi kommer inte att kunna visa riktiga FPS-grafer och inspelade videor i olika lägen. Istället testade vi genomsnittliga och momentana bildfrekvenser per sekund med ett välkänt verktyg vid 60 och 120 Hz bildskärmsuppdateringsfrekvenser med hjälp av V-Sync On, V-Sync Off skärmuppdateringsmetoder, med Adaptive V-Sync och med G- Synkronisera vid 144Hz för att visa skillnaden mellan den nya tekniken och nuvarande 60Hz traditionella V-sync-skärmar.

G-Sync vs. V-Sync På

Vi kommer att börja vår studie med att jämföra lägen med V-Sync On och G-Sync-teknik - detta är den mest avslöjande jämförelsen, som kommer att visa skillnaden mellan metoder som inte har nackdelarna att riva bilden. Först kommer vi att titta på Heaven-testapplikationen med maximala kvalitetsinställningar med en upplösning på 2560 × 1440 pixlar (om du klickar på miniatyrerna öppnas diagrammen i full upplösning):

Som du kan se i grafen är bildfrekvensen med G-Sync aktiverad och utan synkronisering nästan densamma, förutom frekvensen över 60 FPS. Men FPS i läget med den vertikala synkroniseringsmetoden aktiverad är märkbart annorlunda, eftersom bildhastigheten i den kan vara lägre än eller lika med 60 FPS och en multipel av heltal: 1, 2, 3, 4, 5, 6 .. ., eftersom monitorn ibland måste visa samma föregående bildruta under flera uppdateringsperioder (två, tre, fyra och så vidare). Det vill säga de möjliga "stegen" för bildhastigheten med V-Sync På och 60 Hz: 60, 30, 20, 15, 12, 10, ... FPS.

Detta alias är tydligt synligt på den röda linjen i grafen - under körningen av detta test var bildhastigheten ofta 20 eller 30 FPS, och mycket mindre ofta - 60 FPS. Även om med G-Sync och V-Sync Off (Ingen Sync), var det ofta i ett bredare intervall: 35-50 FPS. Med V-Sync aktiverad är denna utmatningshastighet inte möjlig, så monitorn visar alltid 30 FPS i sådana fall - vilket begränsar prestandan och lägger till fördröjning till den totala utmatningstiden.

Det bör noteras att grafen ovan inte visar den momentana bildhastigheten, utan medelvärdena inom en sekund, men i verkligheten kan FPS "hoppa" mycket mer - nästan varje bildruta, vilket orsakar obehaglig ojämnhet och fördröjningar. För att se detta visuellt, här är ett par grafer med momentan FPS - mer exakt med grafer över renderingstid för varje bildruta i millisekunder. Det första exemplet (linjerna är något förskjutna i förhållande till varandra, endast exemplariskt beteende i varje läge visas):

Som du kan se, i det här exemplet, ändras bildhastigheten mer eller mindre smidigt i fallet med G-Sync, och i steg med V-Sync On (det finns enstaka hopp i renderingstid i båda fallen - detta är normalt). Med vsync aktiverat kan renderings- och frame-utgångstider vara 16,7 ms; 33,3 ms; 50 ms, som kan ses på grafen. Sett till FPS motsvarar detta 60, 30 och 20 bilder per sekund. Dessutom finns det ingen speciell skillnad mellan de två linjernas beteende, det finns toppar i båda fallen. Låt oss titta på en annan viktig tidsperiod:

I det här fallet finns det uppenbara "kast" i renderingstiden för ramar, och med dem FPS i fallet med vertikal synkronisering aktiverad. Titta, med V-Sync On är det ett hopp i bildåtergivningstiden från 16,7 ms (60 FPS) till 33,3 ms (30 FPS) och tillbaka - i verkligheten orsakar detta samma obekväma ojämnheter och tydligt synliga ryck i videon sekvens. Jämnheten i rambytena i fallet med G-Sync är mycket högre och att spela i det här läget kommer att bli märkbart bekvämare.

Tänk på FPS-grafen i den andra testapplikationen - Unigine Valley:

I detta riktmärke noterar vi ungefär samma sak som i himlen. Bildhastigheterna i lägena G-Sync och V-Sync Off är nästan desamma (förutom en topp över 60 Hz), och den medföljande V-Sync orsakar en tydlig stegförändring i FPS, som oftast visar 30 FPS, ibland rullande nedåt till 20 FPS och stigande till 60 FPS - typiskt beteende för denna metod, vilket orsakar fördröjningar, ryck och ojämn videosekvens.

I det här underavsnittet återstår det för oss att överväga ett segment från det inbyggda testet av Just Cause 2-spelet:

Detta spel visar perfekt all underlägsenhet hos den föråldrade synkroniseringsmetoden V-Sync On! Med ändrade bildhastigheter från 40 till 60-70 FPS är G-Sync och V-Sync Off-linjerna nästan desamma, men bildhastigheten med V-Sync On når 60 FPS endast i korta segment. Det vill säga, med riktiga GPU-möjligheter för att spela i 40-55 FPS, kommer spelaren att nöja sig med endast 30 FPS.

Dessutom, i den sektion av grafen där den röda linjen hoppar från 30 till 40 FPS, i verkligheten, när du tittar på bilden, finns det en tydlig ojämn bildhastighet - den hoppar från 60 till 30 nästan varje bildruta, vilket uppenbarligen inte lägger till mjukhet och komfort när du spelar. Men kanske med en uppdateringsfrekvens på 120 Hz kommer V-sync att klara sig bättre?

G-Sync vs. V-Sync 60/120Hz

Låt oss ta en titt på de två V-Sync On-lägena vid 60 och 120 Hz uppdateringsfrekvenser och jämföra dem med V-Sync Off (som vi identifierade tidigare, denna linje är nästan identisk med G-Sync). Med en uppdateringsfrekvens på 120 Hz, läggs fler värden till de FPS-steg som vi redan känner till: 120, 40, 24, 17 FPS, etc., vilket kan göra grafen mindre stegrad. Låt oss titta på bildfrekvensen i Heaven benchmark:

Märkbart, 120Hz uppdateringsfrekvens hjälper V-Sync On att uppnå bättre prestanda och jämnare bildhastigheter. I de fall där 20 FPS observeras vid 60 Hz på grafen ger 120 Hz-läget ett mellanvärde på minst 24 FPS. Och 40 FPS istället för 30 FPS syns tydligt på grafen. Men det finns inte färre steg, utan ännu fler, så bildhastigheten vid 120 Hz uppdatering, även om den ändras med en mindre mängd, gör det oftare, vilket också negativt påverkar den totala jämnheten.

Det finns färre ändringar i Valley-riktmärket, eftersom den genomsnittliga bildhastigheten är närmast steget på 30 FPS som är tillgängligt för båda lägena: 60 och 120 Hz uppdateringsfrekvenser. Inaktiverad synkronisering ger mjukare ramövergångar, men med visuella artefakter och V-Sync On-lägen visar återigen stegvisa linjer. I det här underavsnittet återstår det för oss att titta på Just Cause 2-spelet.

Och återigen ser vi tydligt hur bristfällig den vertikala synkroniseringen är, vilket inte ger en jämn rambyte. Även att gå till 120Hz uppdateringsfrekvens ger V-Sync On bara några extra FPS "steg" - bildhastighet hoppar fram och tillbaka från ett steg till nästa - allt detta är väldigt obehagligt när du tittar på animerade 3D-scener, du kan ta vårt ord för det eller titta på videoexemplen ovan igen.

Effekt av utdatametod på genomsnittlig bildhastighet

Och vad händer med den genomsnittliga bildhastigheten när alla dessa synkroniseringslägen är aktiverade, hur påverkar inkluderingen av V-Sync och G-Sync den genomsnittliga prestandan? Du kan grovt uppskatta hastighetsförlusten även genom FPS-graferna som visas ovan, men vi kommer också att ge de genomsnittliga bildhastigheter som vi fick under testningen. Den första kommer igen att vara Unigine Heaven: